Practical GenAI roadmap: La arquitectura encoder-decoder

La estructura fundamental detrás de los modelos que escriben, traducen y resumen

En la era de los grandes modelos de lenguaje, entender cómo se produce una secuencia de texto no es solo una curiosidad técnica: es una ventaja competitiva.

Durante años, el perfil de científico de datos se ha centrado en tareas de predicción, clasificación o segmentación. Pero con la llegada de los modelos generativos, el foco ha cambiado. Hoy, la clave no está en predecir un número, sino en generar una secuencia coherente. Y ahí es donde entra la arquitectura encoder-decoder.

1. ¿Qué es una arquitectura encoder-decoder?

La arquitectura encoder-decoder es una estructura secuencia-a-secuencia (seq2seq). Su función principal es transformar una entrada secuencial (por ejemplo, una frase) en otra secuencia, normalmente de distinta longitud o naturaleza.

📌 Ejemplo clásico: Traducción automática

Entrada:

"The cat ate the mouse"Salida:

"Le chat a mangé la souris"

El proceso consta de dos bloques fundamentales:

Encoder: procesa la secuencia de entrada y la codifica en una representación vectorial densa.

Decoder: toma esa representación y genera, paso a paso, la secuencia de salida.

2. Cómo funciona internamente

2.1 El encoder

El encoder recibe los tokens de entrada uno a uno (en modelos clásicos como los RNN) o todos a la vez (en transformers) y genera una representación vectorial que resume toda la secuencia.

En RNNs, se utiliza un estado oculto que se actualiza a cada paso.

En transformers, se aplica atención sobre todos los tokens simultáneamente.

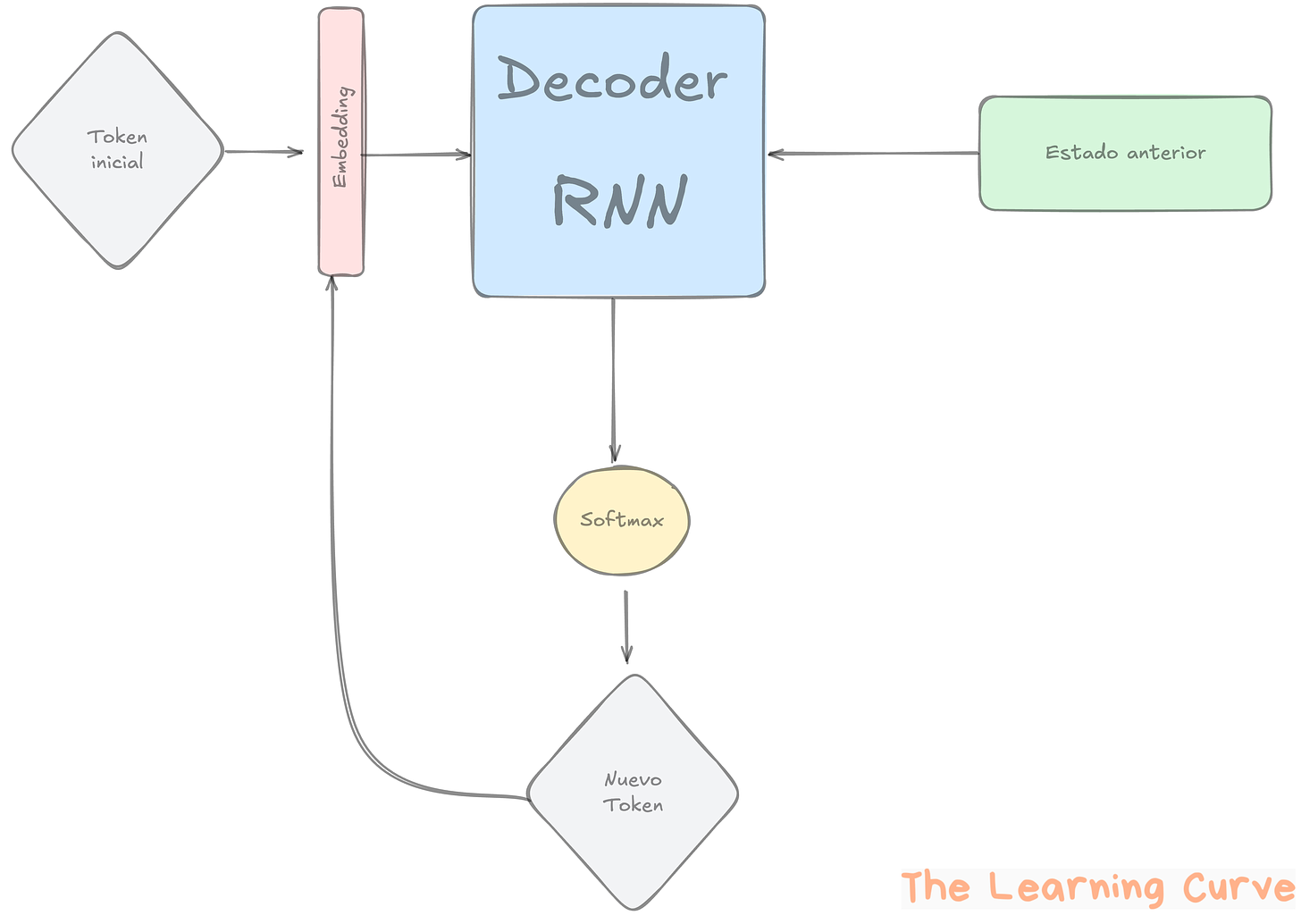

2.2 El decoder

El decoder genera la salida token a token. En cada paso:

Toma la representación del encoder

Usa el token anterior (o un token especial

<GO>al comienzo)Produce una distribución de probabilidad sobre el vocabulario

Se elige el siguiente token con una estrategia de generación (como greedy o beam search)

Si te interesa la estructura encoder-decoder, te dejo un artículo donde hablo de otras de las aplicaciones de esta arquitectura fuera de la IA generativa.

3. El entrenamiento: ¿cómo aprende un modelo encoder-decoder?

3.1 Dataset

Para entrenar este tipo de arquitectura necesitas un conjunto de pares (entrada, salida). Ejemplos:

Traducción: pares de frases en dos idiomas

Pregunta-respuesta: pregunta y su respuesta correcta

Chatbots: historial de conversación y respuesta esperada

3.2 Teacher Forcing

Durante el entrenamiento, el decoder no utiliza su propia salida generada, sino la secuencia de salida correcta desplazada una posición.

Esto se llama teacher forcing y permite que el modelo aprenda más rápido y con mayor estabilidad.

4. La generación: cuando toca escribir

Una vez entrenado, el modelo debe generar texto sin saber la respuesta correcta. Aquí es donde entra el modo autoregresivo:

Se da un prompt (entrada) al encoder.

El decoder arranca con un token

<GO>.Se genera un token, se retroalimenta, se repite hasta llegar a un token

<EOS>o a un límite de longitud.

Estrategias de decodificación

Greedy Search: siempre se elige el token con mayor probabilidad.

Beam Search: se exploran múltiples caminos simultáneamente, manteniendo los más prometedores.

5. ¿Y los transformers?

La arquitectura encoder-decoder no implica el uso de una tecnología concreta. Lo que varía es lo que hay dentro de los bloques.

En modelos antiguos:

Encoder y decoder = RNNs (Recurrent Neural Networks)

En modelos actuales:

Encoder y decoder = Transformers

¿Por qué? Porque permiten:

Procesar toda la secuencia en paralelo

Capturar dependencias largas con el mecanismo de self-attention

De hecho, modelos como T5 o BART están basados en encoder-decoders totalmente construidos con transformers.

6. ¿Qué significa esto para ti como científico de datos?

Pasar del análisis exploratorio al diseño de prompts es un cambio de mentalidad. Pero conocer la arquitectura encoder-decoder te permite:

Evaluar mejor las salidas de un modelo (¿cuándo falla? ¿por qué repite frases?)

Ajustar el entrenamiento si decides fine-tunear modelos generativos

Desarrollar soluciones personalizadas en tareas como resumen automático, generación de respuestas o generación de código

📚 ¿Te gustaría ver todo esto en acción?

En este repositorio tienes un notebook listo para entrenar un modelo encoder-decoder que traduce de inglés a francés.

Sí, entrenar un traductor. Tú mismo, en tu máquina.

Conclusión

La arquitectura encoder-decoder es el esqueleto sobre el que se construye gran parte de la magia de la IA generativa. No es necesario reinventarla desde cero, pero sí comprender sus fundamentos.

Porque entender cómo se genera una secuencia... es el primer paso para generar valor con ella.

Por 5$ puedes comprarte un donut en el aeropuerto, dos cafés aguados en una máquina de hospital, un imán de nevera con forma de flamenco… o apoyar este proyecto y sentirte como Warren Buffett pero con menos traje y más sentido común.