MCP: el USB-C de los agentes de IA

Cómo el protocolo MCP está redefiniendo la forma en que conectamos modelos, datos y personas

Hace unos días escribí que el futuro de las interfaces será por voz. Pero la voz es solo una capa. Lo importante no es cómo le hablamos a la IA, sino qué sabe cuando le hablamos. Y aquí entra un concepto clave:

Los modelos no son tan buenos como su capacidad de razonamiento. Son tan buenos como el contexto que les damos.

El problema es que hasta ahora, el contexto venía a cucharadas. Un PDF aquí, una API allá, una conversación por WhatsApp, un resumen en una app… Pero todo funcionaba de forma aislada. Sin conexión. Como si el modelo tuviera amnesia cada vez que cambiamos de canal.

Ahí es donde entra MCP (Model Context Protocol).

El futuro no es una web bonita. Es que ni siquiera será una web.

Tenía esto guardado desde hace unas semanas. Me lo dejé en borradores porque pensé: igual es pasarse. Pero ya está bien de comerse las palabras.

¿Qué es MCP?

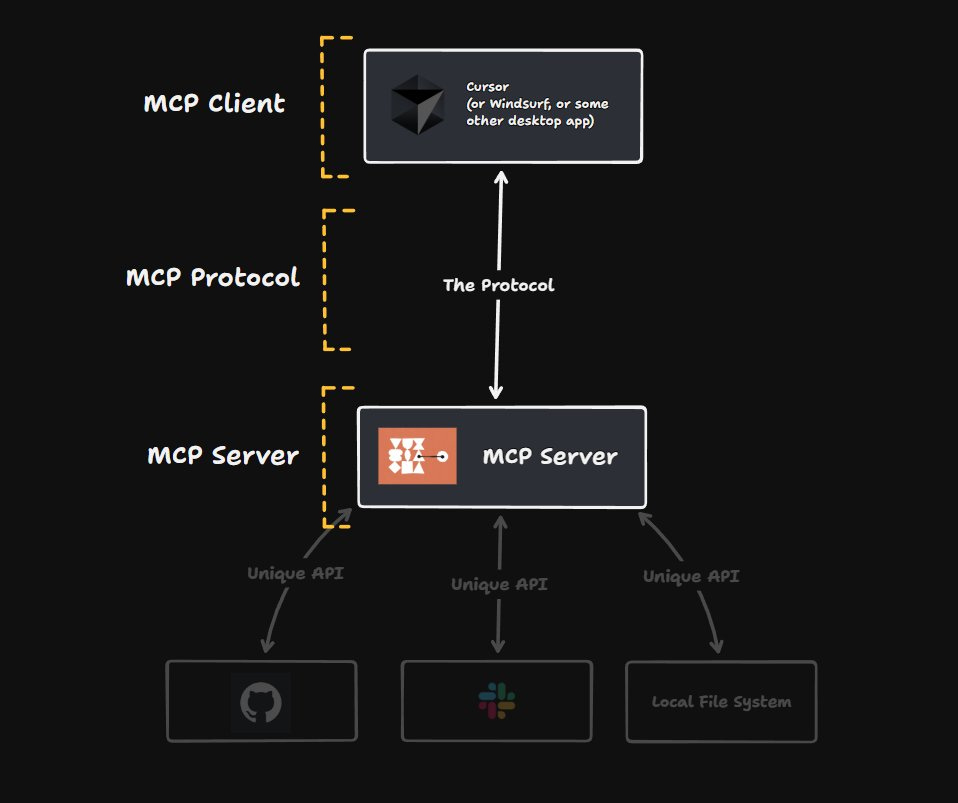

MCP es un protocolo para hablar con agentes de IA usando múltiples canales (texto, voz, imagen, etc.) y múltiples clientes. Es como el USB-C de los asistentes inteligentes: conecta todo con todo, y lo hace con un protocolo común.

¿Tienes un bot de atención al cliente? Puedes conectarlo por texto, voz o incluso WhatsApp.

¿Tienes un agente que lee PDFs? Puedes integrarlo con otros agentes que consultan bases de datos o que escuchan voz en tiempo real.

¿Tienes varios agentes que hacen tareas distintas? Puedes encadenarlos.

Todo eso, con una interfaz unificada, asincrónica y extensible. Literalmente: puedes montar infraestructura de agentes con nodos especializados, como si fueran microservicios de IA.

Arquitectura modular: servidores que hablan con servidores

Una de las grandes ventajas de MCP es que no estás limitado a una única instancia. Puedes:

Lanzar varios agentes especializados (uno para documentos, otro para análisis de datos, otro para planificación, etc.)

Conectarlos entre sí en cadena o en paralelo.

Usar un servidor como cliente de otro servidor MCP (sí, como una IA que pregunta a otra IA).

Coordinar respuestas con lógica condicional, embeddings compartidos o reglas específicas.

Por ejemplo, podrías tener:

Un agente principal que recibe la entrada de usuario.

Un agente de recuperación de contexto (RAG) que busca documentos relevantes.

Un agente de cálculo que llama a una API externa o hace funciones matemáticas.

Un agente de voz que convierte la respuesta a audio.

Todo orquestado con MCP. Cada uno escuchando en su endpoint. Cada uno respondiendo a lo que sabe hacer mejor.

Y si uno no sabe qué responder, lo pasa al siguiente. Como un equipo de expertos con un solo cerebro compartido.

¿Dónde puedo probar esto?

Te dejo aquí algunos servidores públicos MCP para empezar a jugar:

🔌 MCP Server en Hugging Face – demo multimodal en Hugging Face con OpenAI.

🔁 MCP Server en Vercel – proxy MCP simple con logs.

🧠 MCP Server de Jina AI – ejemplo avanzado de Jina con entrada multimodal.

Puedes probarlos usando herramientas como:

mcp-client-pythonLangGraph MCP Agentjina-ai/mcp

También puedes usar LlamaIndex o LangGraph para montar tus propios agentes y conectarlos por MCP sin tener que pelearte con sockets o headers personalizados.

Recursos para aprender y construir

Si te apetece ir más allá del “hola mundo”:

📘 Guía oficial de MCP en LangGraph – paso a paso con código y arquitectura.

🧑🏫 Curso de agentes multimodales de LlamaIndex – con ejemplos de conexión por voz, API y texto.

Y si quieres ver un ejemplo real de uso en producción… pronto te contaré más en el podcast.

Por 5$ puedes comprarte un donut en el aeropuerto, dos cafés aguados en una máquina de hospital, un imán de nevera con forma de flamenco… o apoyar este proyecto y sentirte como Warren Buffett pero con menos traje y más sentido común.

¿Por qué importa esto?

Porque en este mundo lleno de hype con agentes que parecen sacados de una demo de feria, MCP te permite construir cosas de verdad:

Agentes que trabajan con tus datos reales.

Interfaces que se adaptan a cómo tú te comunicas.

Sistemas que crecen modularmente, como una arquitectura viva.

Esto no es el futuro. Es ya. Y, como pasó con REST o GraphQL, el que entienda el protocolo primero, lleva ventaja.

¿Te interesa ver un ejemplo real?

Estoy preparando varios agentes usando MCP en proyectos propios (desde asistentes por voz hasta conectores con WhatsApp y dashboards internos).

Si quieres que publique uno paso a paso, dime:

👉 ¿Qué te gustaría ver funcionando?

¿Un agente que hable por voz?

¿Uno que lea PDFs y los resuma?

¿Un orquestador que combine varios agentes especializados?

Responde a este post, deja un comentario o mándame un email. Estoy montando una demo pública y puedo priorizar lo que más os interese.

Y si este contenido te ha servido (aunque sea un poco), no hace falta que te apuntes a nada ni que compres nada. Todo esto es gratuito y seguirá siéndolo.

Solo te pido una cosa:

👉 dale like, compártelo o mándaselo a alguien que esté construyendo con IA.

Para ti es un clic. Para mí es seguir escribiendo.

— Daniel

Hola Daniel, muy interesante este post, aunque creo que se me escapan muchas, cosas, jeje.

Quiero empezar por lo básico que sería poder conectarme usando MCP, había pensando usar Python, a una bbdd en IBM DB2 y tener una IA en local con Ollama y que pudiera hacerle consultas a la bbdd, y luego pasar la respuesta a una web interna.

Seguro que será algo ya superado, pero para los muy novatos un ejemplo de este tipo te lo agradeceríamos.

Te digo leyendo con atención :).

Gracias por compartir tu conocimiento!

Como va esto Daniel. Que ritmo lleva. Gracias por este post tan bien explicado. Nosotros estamos implementando alguno con MAKE aunque creo que son mejorables para hablar con aplicaciones externas, dentro de MAKE van muy bien. Pero después de leerte me siento un novato en esto.