Como correr LLMs open-source en tu PC con Ollama

soy un rata y me niego a pagar APIs

Sí, lo confieso: soy un rata. No me gusta pagar por las APIs de OpenAI solo para hacer pruebas. ¿Por qué? Porque si puedo evitarlo y usar algo que corre en mi pc, mejor que mejor. Y para todos los que sois como yo, hoy os traigo un tutorial para correr modelos de lenguaje (LLMs) open-source desde tu ordenador con Ollama.

¿Qué vas a necesitar? Solo tu PC, un par de clics y unas líneas de comando. Nada de alquilar servidores ni hipotecar tu casa para costear APIs.

Paso 1: Descarga e instala Ollama

Ve a Ollama.com, descarga la herramienta y sigue los pasos de instalación. No hay nada peor que una web que parece sencilla pero te pide registrarte, verificar correo, y, sorpresa: “introduce el código que te hemos enviado por fax”. Aquí no hay de eso, te lo prometo.

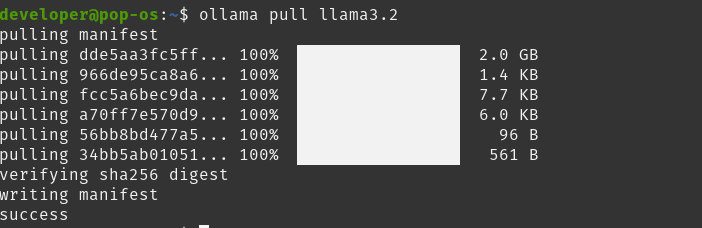

Paso 2: Descarga el modelo

Una vez instalado, abre tu terminal (sí, esa pantalla negra que hace que la gente piense que hackeas la NASA) y ejecuta el siguiente comando para descargar llama3.2:

ollama pull llama3.2Verás cómo empieza a descargar y, en unos minutos, ¡tendrás un LLM listo para charlar! Nada de "pagos por tokens" ni "consumo de créditos", aquí tú eres el jefe.

Paso 3: Pruébalo

Ahora que ya tienes el modelo en tu máquina, hazle preguntas, pídele recetas, o incluso que te cuente un chiste malo. La línea de comando es tu parque de juegos:

ollama run llama3.2Hasta aquí todo bien. Tienes tu modelo en una interfaz funcionando. Pero, ¿y si quieres más? ¿Y si quieres que llama3.2 no solo responda, sino que lo haga como Mario, el fontanero más famoso del mundo? Aquí es donde la cosa se pone divertida: la personalización.

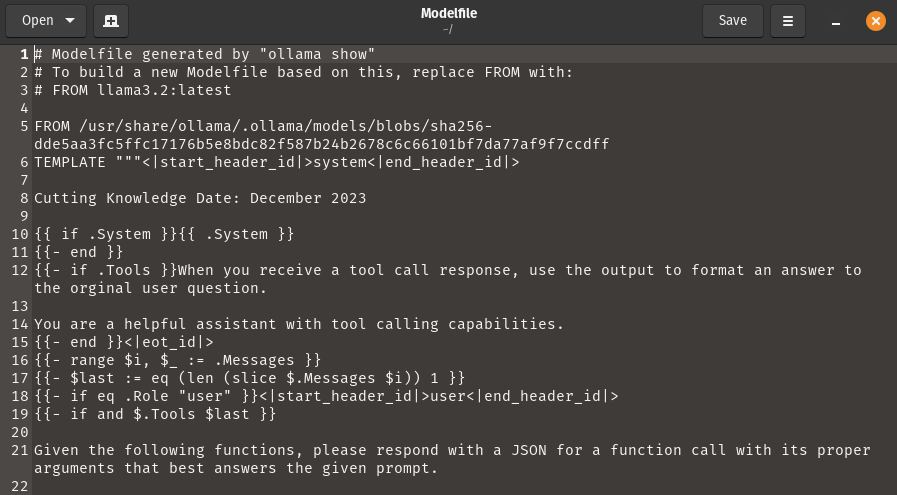

Personaliza el modelo para que hable como tú quieras

La magia de Ollama es que no solo te permite ejecutar modelos open-source, sino también personalizarlos. Y sí, esto significa que puedes hacer que llama3.2 adopte el tono y el estilo que tú decidas. Te explico cómo:

Haz una copia del archivo de modelo: Duplica el archivo de configuración del modelo para no tocar el original.

ollama show llama3.2 --modelfile > ModelfileEdita el archivo: Abre el archivo copiado en tu editor de texto favorito y busca la sección

TEMPLATE. Aquí es donde la magia ocurre. Cámbiala para que llama3.2 inicie todas sus respuestas con un “¡Mamma mia!” y use expresiones de Mario.Guarda y ejecuta tu nuevo modelo personalizado:

ollama create mario --file Modelfileollama run mario

Extra: Integración con frameworks (y una sorpresa para los programadores)

Ollama no solo corre modelos de lenguaje en tu máquina, sino que se lleva de maravilla con frameworks de orquestación de LLMs como LlamaIndex y Langchain. Esto significa que puedes usar Ollama para construir aplicaciones más complejas y robustas, todo sin pagar un solo euro por API.

¿Eres programador y usas Visual Studio Code (VSCode)? Aquí viene lo bueno: Ollama tiene una extensión para VSCode. Con esta extensión, puedes probar modelos, hacer preguntas y trabajar con tus LLMs directamente desde tu entorno de desarrollo. Si quieres, puedo enseñarte cómo instalarla y configurarla para que tengas un flujo de trabajo impecable.

La personalización y la integración nunca habían sido tan sencillas. Así que, ¿a qué esperas para experimentar con Ollama?

Este post es una copia de https://www.dailydoseofds.com/p/run-llms-locally-with-ollama/

To bienn, un poco lento...voy a cargarlo en Jetson 2, Javier y Nano a ver en que quedan ese minuto y pico de la pregunta de calcular los primeros 10 decimales de Pi. Molaría lo de integrarlo en el entorno de desarrollo, el mio es IntelliJ de Jetbrains. Graciass